询问LLM Plus RL:有意使用虚假奖励,数学基准也大

2025-05-30 10:36

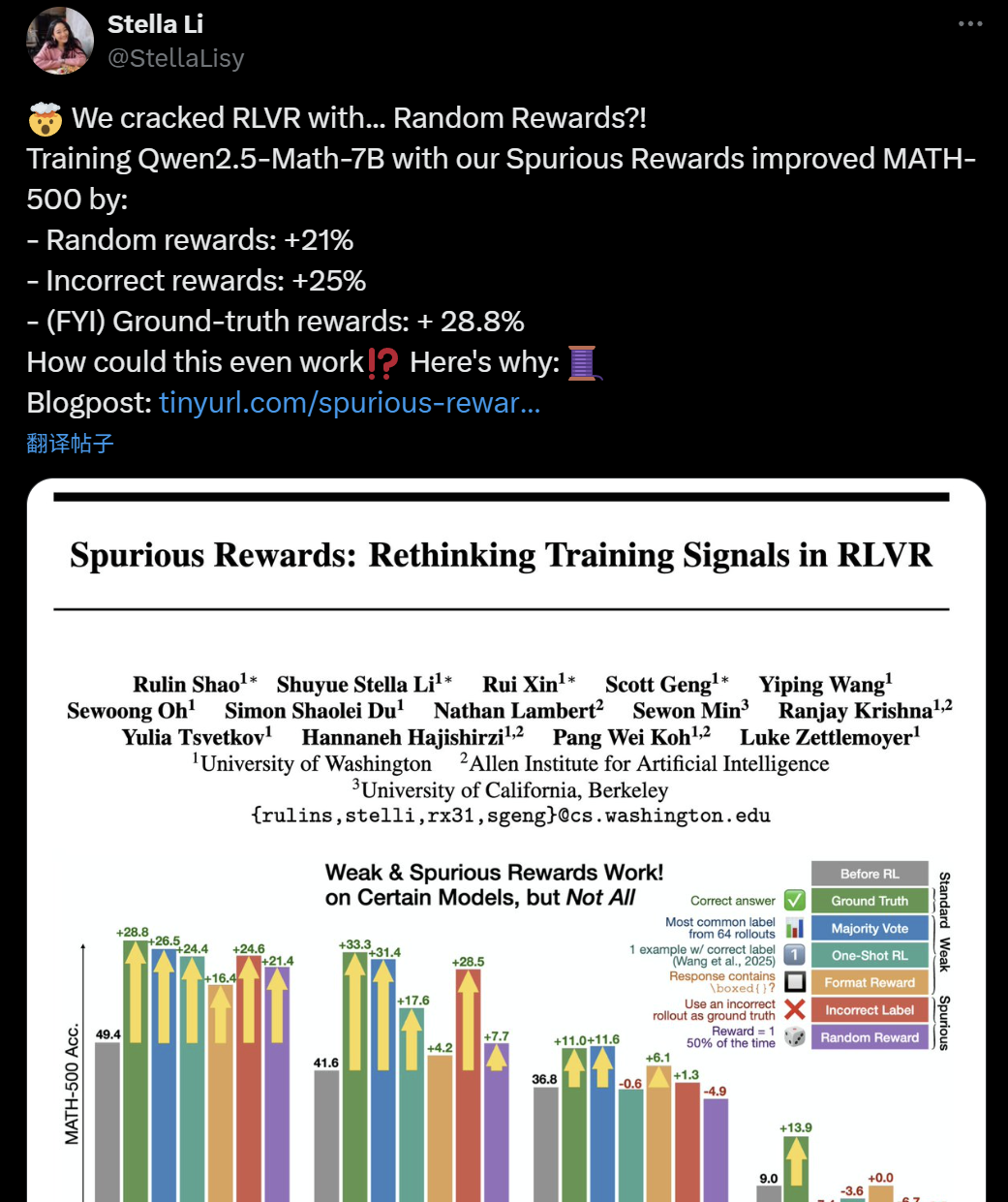

机器核心报告的编辑:Zenan,+0我们已经培训很长时间了,我们的培训是什么?这是今年最“有趣”的角色。发表本文后,将询问所有大型语言模型(LLM) +强化学习(RL)是否有意义。本周二,华盛顿大学的一篇论文,艾伦的人工智能实验室和伯克利在AI世界中引发的论文。论文:虚假奖励:RLVR项目链接上的重新思考培训信号:https://github.com/ruixin31/rethink_rlvr/tree/main拒绝了那些拒绝的人最近拒绝了最近在大型领域中学习增强的流行方法。他们发现,使用错误的奖励来训练QWEN2.5-MATH-7B模型也可以提高数学500分数。如果这是一个随机的奖励,那么商标可能会提高21%,如果这是错误的奖励,则商标可以提高25%(实际奖励可以提高28.8%)。这是怎么回事?是大MO的训练技术DELS真的有用吗?这项工作的一组写了一个博客来介绍:研究(RLVR)(RLVR)(RLVR)(RLVR)(RLVR)的传统观点,对近期的传统观点,对奖励强化的验证研究(RLVR)已成为增强认识大语言模型(LLM)能力的标准方法。传统上,高质量信号对于有效的RLVR培训至关重要。最近的研究提出了这一假设的挑战,表明使用RLVR进行单个样本或不支持样本的训练仍然可以在QWEN-MATH模型中产生重大发展。但是,我们不禁要问:Swhere单样本训练信号是来自还是不支持RLVR?为了提供重大的RLVR培训信号,奖励的最低要求是什么?我们的发现令人惊讶。错误的奖励,无论是随机或错误,都可以显着改善QWEN-MATH的表现。我们发现,RLVR可以通过So称为“ FAL”大大提高数学推理能力se reward" - signals with small or even misleading guidance. Here are some interesting -kind rewards we've tried: Format Rewards: Reward only because the answer contains \ boxed {} - Rewards for the answer contain \ boxed {} expression. This format is also a format specified in the prompts provided by the system to the model, thus providing a concept of "Tips Follow". Random Reward: Fully Arbitrary Feedback - Literal na Kahulugan: 1功功(随机。 Sagot功夫Ang Sagot Ay Tiyak Na Sagot,Pagsasanay Sa Isang子集的Ang样品Ng Mga Pinaka -karaniwang sagot ng Modelo在Gamitin ang tiyak ang tiyak na sagot bilang bilang bilang bilang bilang bilang ishang ishang ishang ishang ishang iShang iShang ng ng训练中也将与其他弱培训相比。将大多数选票的答案作为标签。单样本增强的研究:虚拟研究的标准研究(RLVR)是在单个样本中进行的。 RLVR Math-500在各种培训信号上进行了150个培训后的精度。我们已经证明,即使是“错误的Gantimpala”也可以为QWEN模型带来大幅改进。应当指出的是,这些奖励信号不适用于其他模型,例如Llama3和Olmo2,因为它们对识别的认可是不同的。从广泛用于AI研究的QWEN2.5-MATH-7B模型开始,我们已经实现了数学基准实际值的实现的工作结果。数学推理,包括QWEN2变体。5-键,Olmo2和Llama3,我们观察到了一些有趣的现象:与Qwen-Math不同,其他模型在“错误的奖励”方面有限。 。它提高了所有模型的性能。当使用真实标签作为简单的GRPO时,我们会看到所有模型S的改进埃里斯(Eries),Qwen和Qwen-Math而不是Llama和Olm模型进行了改进。多数票的结果是什么?先前的研究提出了提高模型相似性的方法。我们发现这对大多数模型确实很有用,但没有奥尔莫。如果只有在包含\\盒装{}的响应时才获得奖励,该怎么办?实验发现,只有产生分析结果的模型训练才能在Moqwen的Delo上取得重大的性能改善 - QWEN2.5-1.5B的完全增加高达49.9%。但是,这种奖励会损害Llama的表现为3.2-3b-instruktura和Olmo2-SFF-7B,分别将表现降低了7.3%和5.3%。值得注意的是,达到高潮后的表现开始逐渐下降。我们认为这是因为该模型已经“学习”了格式,因此进一步的培训不会为其提供其他信息。错误的奖励 - 事情开始变得有趣。我们发现它大大改善了QWEN模型,但对Llama模型没有影响,并且被Olmo-Base和Olmo-SFT模型受损。最后,如果我们将奖励0或1随机分配给模型而不遵循模型本身,会发生什么?它仍然有效吗?您猜测它适用于QWEN型号,但对其他模式不适合。请注意,随机奖励与QWEN2.5-1.5B不起作用,并且仅在近120个步骤后才开始与Qwen2.5-7B一起工作。基于此观察结果,我们对其进行了更长的小时(300步)训练,并发现与其他奖励奖励相比,这些模型的收敛水平较低。这种架构行为表明,RLVR的有效性更多地取决于先前模型的先前功能,而不是管理信号的质量。对未来工作的实用警告QWEN模型已成为RLVR研究的事实上选择的,对开放社区资源进行开放的重量资源和高性能活动 - 一系列有关RLVR的研究已完成D基于Qwen -Sentric中的实验(有关列表,请参见原始NA纸)。但是,我们发现最近的两项研究表明,使用弱的RLVR的使用与QWEN模型效果很好,但是在其他模型家族中,这些结论通常不存在。在试验期间采用的研究:本文建议在测试样本中进行RLVR,并使用多数人的答案在相同的方法(On Policy)下进行投票来计算奖励。单样本增强研究:本文表明,带有样品的RLVR可以在标准练习集中获得与RLVR相当的性能。我们在不同的基本模型中审查了最近仅提出的两个仅提示的不良管理RL -TTRL技术和单个RL样品。我们发现,提出的服装的奖励可以继续与QWEN模型一起使用。但是,在某些例外,这些相同的信号通常不会为其他家庭模型带来好处,理由是我们在练习时观察到的有限手势错误的奖励。因此,我们建议将来的RLVR研究应在其他模型上得到证明。是什么使RLVR在错误的奖励中有效?现在,您可能会很好奇 - 为什么会发生这种情况? ?为什么所有这些错误的奖励在QWEN-MATH模型中都准确?魔术在哪里?通常,我们表明RLVR训练结果的差异是由于每个模型在预训练期间学到的各种特定理解技术所致。特别是,RLVR可以很容易地选择某些方法,而其他方法可能更难显示或不存在。我们已经确定了一种生成代码以帮助数学推理的预储存方法,QWEN-MATH可以有效地使用,而其他家庭使用的使用量较少。我们将把被调查的代码推理为一个照明的研究案例,但这不是一个完整的解释:我们注意到一些其他行为很容易选择并经常与性能相关联,例如“不重复”。有关更多详细信息,请参阅论文。一项照明案例研究:通过仔细分析的代码推理,我们找到了一个关键的观点:甚至在RLVR培训之前,Qwen-Math生成了Python代码,以解决数学问题的时间65.0%。更令人惊奇的是 - 没有执行代码,它通常构成代码输出的纠正以及对问题的正确答案。但是,其他模型中不存在频繁和质量代码推理技能。这是Qwen-Math-7b如何准确预测15个数字之后的一个示例,其另一个比iPhone计算器高100%。 QWEN2.5-MATH-7B的代码推理响应的示例。此问题是从Math-500测试集中随机选择的。请注意,代码及其实现结果是由QWEN2.5-MATH-7B自动进程生成的。模型中未提供外部代码转换器。应用RLVR后,该代码频率平均增加到90%以上奖励质量的SS。推理技术的这种变化(而不是获得新的推理技能)似乎是改善SA性能驾驶的原因。 QWEN模型学会了通过RLVR培训使用更多代码推理。从语言识别到代码理解有效地提高了性能。对于QWEN-MATH和QWEN模型,频率代码与性能高度链接。代码越多 - 答案越正确,反之亦然。但是,在产生代码但无法产生代码质量的模型中(例如OLMO2-7B-SF),这种关系恰恰相反。细粒度的准确性跟踪 - 我们只能选择正确的推理方法而受益?更有趣的是,我们跟踪RLVR之前和之后理解技术变化的问题,并审查了表演的存在的位置。我们发现,错误的奖励在将模型模型转换为Pancode方面更为根本,并且RAREly在语言的自然推理中改变了原始代码推理的起源。令人惊讶的是,看起来基于假奖励的RLVR可以做出正确的选择 - 对于那些自然识别代码识别的人来说,性能急剧增加了几乎55%。另一方面,真正的标签奖励提高了自然语言识别60.2%的表现!下面的流程图包含更详细的说明。我们进一步贡献了方法转化的每种态度的贡献,即具有每个模型的性能。看到这一点非常有凝聚力:如果模型与代码的推理(代码准确性,语言的准确性)很好,则RLVR的好处主要来自从语言到代码推理的转换;如果模型不擅长COD Reasoning(代码准确性,语言精度),则RLVR的好处在很大程度上源于从语言中转换为asoning代码。成功的自举理解技术的奖励的平均计算略有助长了性能的总体好处。基于我们首先注意到的这些强相关性,我们假设代码推理是导致出色数学性能的QWEN模型的理性行为之一。为了检验我们的假设,我们明确防止该模型通过提示和增强研究产生代码推理。我们注意到在所有测试模型中,代码的识别频率与基准性能之间存在很强的相关性。 (相关的方向取决于特定模型代码的质量)。通过煽动推理归纳法规,我们通过简单地激励句子“让它使用Python来解决它”来开始其响应。这种简单的方法可显着提高QWEN-MATH模型的性能,但降低了Llama和Olm模型的性能。机智H强化学习(RL)激发了由于实验成功而激发代码推理的原因,我们设计了一个额外的虚假奖励:只要模型响应包含字符串python,就可以奖励它。这极大地鼓励所有模型使用代码推理(超过99%的响应包括50个培训步骤后的代码)。在下图中,我们显示出类似的趋势,但是如果我们使用强化研究来训练模型以使用python的大量守则,那么效果将会更加重要。 QWEN-MATH和QWEN2.5-7B模型的性能有所改善,而其他模型的性能却有所下降。但是为什么要随机呢?当我们看到训练曲线的攀登以及随机奖励()0.5时,我们感到困惑。一个完全毫无意义和自由的奖励如何真正促进模型研究?具有讽刺意味其他。在进行GRPO之后,我们发现农作物的术语可以是关键。我们通过三种方法进行了一项关于切割因子的消融研究:(a)直接在计算损失计算中禁用范围。 (b)调整训练批量的大小,并减少与该方法相对应的还原模型。 (c)减少推导的批量大小以保持相等的条件。程序(b)和(c)确保仅在每个减少步骤中都有梯度更新,因此自然避免了作物障碍。在QWEN2.5-MATH-7B模型中,对小组的作物术语进行消融研究时的性能频率和推理代码。随机奖励与废话一起练习会增加代码识别模式并提高性能。在使用通常的GRPO作物的情况下,随机奖励是Qwenang 2.5-MATH-7B携带约21%的性能提高,并增加了代码合并模式。但是,当我们删除作物的影响时f上述三种方法中的任何一种,随机奖励并未带来改进。我们认为这是由于GRPO本身公式的偏差,我们将在下面详细解释。在裁剪的作用下,随机奖励不会教授模型活动的质量 - 规定,它们触发了集中注意力集中在模型上对识别模式现有分布的影响。当裁剪被禁用时,这种集中机制正在完全消失。虚假奖励的启示和未来的工作通过增强现有能力来起作用:带虚假奖励的RLVR可以作为加强和突出预训练期间学到的有用表示的机制。当提出了RLVR的新方法时,他们应检查其收益是否会超过该表面模式的披露水平,以激发研究的良好程度。在越来越多的家庭中,关于RL技术的测试主张:由于各种我们建议将未来的RLVR研究在不同的模型上证明,而不是仅依靠单一的“事实标准”选项证明未来的RLVR研究,因为我们已经证明,即使我们获得最多的奖励,我们也可以轻松地为QWEN模型带来重大好处。首先了解您的模型:我们应该更加意识到,假装过程中所学的识别模式会严重影响RLVR训练行为 - 如果设计假装或使用RLVR的假装模型的方法。参考内容:https:// rethink-s--site/spurious-奖励 - 奖励 - 启用 - rlvr-1f4DF34DAC18809488858F95AEB88888872F

机器核心报告的编辑:Zenan,+0我们已经培训很长时间了,我们的培训是什么?这是今年最“有趣”的角色。发表本文后,将询问所有大型语言模型(LLM) +强化学习(RL)是否有意义。本周二,华盛顿大学的一篇论文,艾伦的人工智能实验室和伯克利在AI世界中引发的论文。论文:虚假奖励:RLVR项目链接上的重新思考培训信号:https://github.com/ruixin31/rethink_rlvr/tree/main拒绝了那些拒绝的人最近拒绝了最近在大型领域中学习增强的流行方法。他们发现,使用错误的奖励来训练QWEN2.5-MATH-7B模型也可以提高数学500分数。如果这是一个随机的奖励,那么商标可能会提高21%,如果这是错误的奖励,则商标可以提高25%(实际奖励可以提高28.8%)。这是怎么回事?是大MO的训练技术DELS真的有用吗?这项工作的一组写了一个博客来介绍:研究(RLVR)(RLVR)(RLVR)(RLVR)(RLVR)的传统观点,对近期的传统观点,对奖励强化的验证研究(RLVR)已成为增强认识大语言模型(LLM)能力的标准方法。传统上,高质量信号对于有效的RLVR培训至关重要。最近的研究提出了这一假设的挑战,表明使用RLVR进行单个样本或不支持样本的训练仍然可以在QWEN-MATH模型中产生重大发展。但是,我们不禁要问:Swhere单样本训练信号是来自还是不支持RLVR?为了提供重大的RLVR培训信号,奖励的最低要求是什么?我们的发现令人惊讶。错误的奖励,无论是随机或错误,都可以显着改善QWEN-MATH的表现。我们发现,RLVR可以通过So称为“ FAL”大大提高数学推理能力se reward" - signals with small or even misleading guidance. Here are some interesting -kind rewards we've tried: Format Rewards: Reward only because the answer contains \ boxed {} - Rewards for the answer contain \ boxed {} expression. This format is also a format specified in the prompts provided by the system to the model, thus providing a concept of "Tips Follow". Random Reward: Fully Arbitrary Feedback - Literal na Kahulugan: 1功功(随机。 Sagot功夫Ang Sagot Ay Tiyak Na Sagot,Pagsasanay Sa Isang子集的Ang样品Ng Mga Pinaka -karaniwang sagot ng Modelo在Gamitin ang tiyak ang tiyak na sagot bilang bilang bilang bilang bilang bilang ishang ishang ishang ishang ishang iShang iShang ng ng训练中也将与其他弱培训相比。将大多数选票的答案作为标签。单样本增强的研究:虚拟研究的标准研究(RLVR)是在单个样本中进行的。 RLVR Math-500在各种培训信号上进行了150个培训后的精度。我们已经证明,即使是“错误的Gantimpala”也可以为QWEN模型带来大幅改进。应当指出的是,这些奖励信号不适用于其他模型,例如Llama3和Olmo2,因为它们对识别的认可是不同的。从广泛用于AI研究的QWEN2.5-MATH-7B模型开始,我们已经实现了数学基准实际值的实现的工作结果。数学推理,包括QWEN2变体。5-键,Olmo2和Llama3,我们观察到了一些有趣的现象:与Qwen-Math不同,其他模型在“错误的奖励”方面有限。 。它提高了所有模型的性能。当使用真实标签作为简单的GRPO时,我们会看到所有模型S的改进埃里斯(Eries),Qwen和Qwen-Math而不是Llama和Olm模型进行了改进。多数票的结果是什么?先前的研究提出了提高模型相似性的方法。我们发现这对大多数模型确实很有用,但没有奥尔莫。如果只有在包含\\盒装{}的响应时才获得奖励,该怎么办?实验发现,只有产生分析结果的模型训练才能在Moqwen的Delo上取得重大的性能改善 - QWEN2.5-1.5B的完全增加高达49.9%。但是,这种奖励会损害Llama的表现为3.2-3b-instruktura和Olmo2-SFF-7B,分别将表现降低了7.3%和5.3%。值得注意的是,达到高潮后的表现开始逐渐下降。我们认为这是因为该模型已经“学习”了格式,因此进一步的培训不会为其提供其他信息。错误的奖励 - 事情开始变得有趣。我们发现它大大改善了QWEN模型,但对Llama模型没有影响,并且被Olmo-Base和Olmo-SFT模型受损。最后,如果我们将奖励0或1随机分配给模型而不遵循模型本身,会发生什么?它仍然有效吗?您猜测它适用于QWEN型号,但对其他模式不适合。请注意,随机奖励与QWEN2.5-1.5B不起作用,并且仅在近120个步骤后才开始与Qwen2.5-7B一起工作。基于此观察结果,我们对其进行了更长的小时(300步)训练,并发现与其他奖励奖励相比,这些模型的收敛水平较低。这种架构行为表明,RLVR的有效性更多地取决于先前模型的先前功能,而不是管理信号的质量。对未来工作的实用警告QWEN模型已成为RLVR研究的事实上选择的,对开放社区资源进行开放的重量资源和高性能活动 - 一系列有关RLVR的研究已完成D基于Qwen -Sentric中的实验(有关列表,请参见原始NA纸)。但是,我们发现最近的两项研究表明,使用弱的RLVR的使用与QWEN模型效果很好,但是在其他模型家族中,这些结论通常不存在。在试验期间采用的研究:本文建议在测试样本中进行RLVR,并使用多数人的答案在相同的方法(On Policy)下进行投票来计算奖励。单样本增强研究:本文表明,带有样品的RLVR可以在标准练习集中获得与RLVR相当的性能。我们在不同的基本模型中审查了最近仅提出的两个仅提示的不良管理RL -TTRL技术和单个RL样品。我们发现,提出的服装的奖励可以继续与QWEN模型一起使用。但是,在某些例外,这些相同的信号通常不会为其他家庭模型带来好处,理由是我们在练习时观察到的有限手势错误的奖励。因此,我们建议将来的RLVR研究应在其他模型上得到证明。是什么使RLVR在错误的奖励中有效?现在,您可能会很好奇 - 为什么会发生这种情况? ?为什么所有这些错误的奖励在QWEN-MATH模型中都准确?魔术在哪里?通常,我们表明RLVR训练结果的差异是由于每个模型在预训练期间学到的各种特定理解技术所致。特别是,RLVR可以很容易地选择某些方法,而其他方法可能更难显示或不存在。我们已经确定了一种生成代码以帮助数学推理的预储存方法,QWEN-MATH可以有效地使用,而其他家庭使用的使用量较少。我们将把被调查的代码推理为一个照明的研究案例,但这不是一个完整的解释:我们注意到一些其他行为很容易选择并经常与性能相关联,例如“不重复”。有关更多详细信息,请参阅论文。一项照明案例研究:通过仔细分析的代码推理,我们找到了一个关键的观点:甚至在RLVR培训之前,Qwen-Math生成了Python代码,以解决数学问题的时间65.0%。更令人惊奇的是 - 没有执行代码,它通常构成代码输出的纠正以及对问题的正确答案。但是,其他模型中不存在频繁和质量代码推理技能。这是Qwen-Math-7b如何准确预测15个数字之后的一个示例,其另一个比iPhone计算器高100%。 QWEN2.5-MATH-7B的代码推理响应的示例。此问题是从Math-500测试集中随机选择的。请注意,代码及其实现结果是由QWEN2.5-MATH-7B自动进程生成的。模型中未提供外部代码转换器。应用RLVR后,该代码频率平均增加到90%以上奖励质量的SS。推理技术的这种变化(而不是获得新的推理技能)似乎是改善SA性能驾驶的原因。 QWEN模型学会了通过RLVR培训使用更多代码推理。从语言识别到代码理解有效地提高了性能。对于QWEN-MATH和QWEN模型,频率代码与性能高度链接。代码越多 - 答案越正确,反之亦然。但是,在产生代码但无法产生代码质量的模型中(例如OLMO2-7B-SF),这种关系恰恰相反。细粒度的准确性跟踪 - 我们只能选择正确的推理方法而受益?更有趣的是,我们跟踪RLVR之前和之后理解技术变化的问题,并审查了表演的存在的位置。我们发现,错误的奖励在将模型模型转换为Pancode方面更为根本,并且RAREly在语言的自然推理中改变了原始代码推理的起源。令人惊讶的是,看起来基于假奖励的RLVR可以做出正确的选择 - 对于那些自然识别代码识别的人来说,性能急剧增加了几乎55%。另一方面,真正的标签奖励提高了自然语言识别60.2%的表现!下面的流程图包含更详细的说明。我们进一步贡献了方法转化的每种态度的贡献,即具有每个模型的性能。看到这一点非常有凝聚力:如果模型与代码的推理(代码准确性,语言的准确性)很好,则RLVR的好处主要来自从语言到代码推理的转换;如果模型不擅长COD Reasoning(代码准确性,语言精度),则RLVR的好处在很大程度上源于从语言中转换为asoning代码。成功的自举理解技术的奖励的平均计算略有助长了性能的总体好处。基于我们首先注意到的这些强相关性,我们假设代码推理是导致出色数学性能的QWEN模型的理性行为之一。为了检验我们的假设,我们明确防止该模型通过提示和增强研究产生代码推理。我们注意到在所有测试模型中,代码的识别频率与基准性能之间存在很强的相关性。 (相关的方向取决于特定模型代码的质量)。通过煽动推理归纳法规,我们通过简单地激励句子“让它使用Python来解决它”来开始其响应。这种简单的方法可显着提高QWEN-MATH模型的性能,但降低了Llama和Olm模型的性能。机智H强化学习(RL)激发了由于实验成功而激发代码推理的原因,我们设计了一个额外的虚假奖励:只要模型响应包含字符串python,就可以奖励它。这极大地鼓励所有模型使用代码推理(超过99%的响应包括50个培训步骤后的代码)。在下图中,我们显示出类似的趋势,但是如果我们使用强化研究来训练模型以使用python的大量守则,那么效果将会更加重要。 QWEN-MATH和QWEN2.5-7B模型的性能有所改善,而其他模型的性能却有所下降。但是为什么要随机呢?当我们看到训练曲线的攀登以及随机奖励()0.5时,我们感到困惑。一个完全毫无意义和自由的奖励如何真正促进模型研究?具有讽刺意味其他。在进行GRPO之后,我们发现农作物的术语可以是关键。我们通过三种方法进行了一项关于切割因子的消融研究:(a)直接在计算损失计算中禁用范围。 (b)调整训练批量的大小,并减少与该方法相对应的还原模型。 (c)减少推导的批量大小以保持相等的条件。程序(b)和(c)确保仅在每个减少步骤中都有梯度更新,因此自然避免了作物障碍。在QWEN2.5-MATH-7B模型中,对小组的作物术语进行消融研究时的性能频率和推理代码。随机奖励与废话一起练习会增加代码识别模式并提高性能。在使用通常的GRPO作物的情况下,随机奖励是Qwenang 2.5-MATH-7B携带约21%的性能提高,并增加了代码合并模式。但是,当我们删除作物的影响时f上述三种方法中的任何一种,随机奖励并未带来改进。我们认为这是由于GRPO本身公式的偏差,我们将在下面详细解释。在裁剪的作用下,随机奖励不会教授模型活动的质量 - 规定,它们触发了集中注意力集中在模型上对识别模式现有分布的影响。当裁剪被禁用时,这种集中机制正在完全消失。虚假奖励的启示和未来的工作通过增强现有能力来起作用:带虚假奖励的RLVR可以作为加强和突出预训练期间学到的有用表示的机制。当提出了RLVR的新方法时,他们应检查其收益是否会超过该表面模式的披露水平,以激发研究的良好程度。在越来越多的家庭中,关于RL技术的测试主张:由于各种我们建议将未来的RLVR研究在不同的模型上证明,而不是仅依靠单一的“事实标准”选项证明未来的RLVR研究,因为我们已经证明,即使我们获得最多的奖励,我们也可以轻松地为QWEN模型带来重大好处。首先了解您的模型:我们应该更加意识到,假装过程中所学的识别模式会严重影响RLVR训练行为 - 如果设计假装或使用RLVR的假装模型的方法。参考内容:https:// rethink-s--site/spurious-奖励 - 奖励 - 启用 - rlvr-1f4DF34DAC18809488858F95AEB88888872F 相关推荐

Copyright © 2024-2026 pg麻将胡了2_pg娱乐电子游戏 版权所有

+86-123-4567

+86-123-4567 天朝天堂路99号

天朝天堂路99号